อุปกรณ์คอมพิวเตอร์อ่างเก็บน้ำทางกายภาพแบบใหม่เลียนแบบพฤติกรรมซินแนปส์ของมนุษย์เพื่อการประมวลผล AI ที่มีประสิทธิภาพ อุปกรณ์คอมพิวเตอร์อ่างเก็บน้ำทางกายภาพแบบใหม่ที่มีค่าคงที่ของเวลาที่ควบคุมได้เลียนแบบพฤติกรรมซินแนปส์ของมนุษย์เพื่อการประมวลผล AI ขอบที่มีประสิทธิภาพ อุปกรณ์นี้สามารถตรวจจับการเคลื่อนไหวของมนุษย์ได้อย่างแม่นยำในขณะที่ใช้พลังงานน้อยมาก - Cr. Takashi Ikuno / Tokyo University of Science, Japan

นักวิจัยจากมหาวิทยาลัยวิทยาศาสตร์โตเกียว (Tokyo University of Science) ได้พัฒนาอุปกรณ์คอมพิวเตอร์แบบอ่างเก็บน้ำทางกายภาพ (Physical Reservoir Computing) ที่เลียนแบบพฤติกรรมของไซแนปส์ในสมองมนุษย์

อุปกรณ์นี้ใช้เซลล์แสงอาทิตย์ชนิดย้อมสี (Dye-Sensitized Solar Cell) ที่มีความสามารถในการปรับค่าคงที่เวลา (Time Constant) ตามความเข้มของแสงที่ได้รับ ซึ่งช่วยให้สามารถประมวลผลข้อมูลแบบอนุกรมที่มีช่วงเวลาหลากหลายได้อย่างมีประสิทธิภาพ

การทดสอบพบว่าอุปกรณ์นี้สามารถจำแนกการเคลื่อนไหวของมนุษย์ เช่น การงอ การกระโดด การวิ่ง และการเดิน ได้ด้วยความแม่นยำมากกว่า 90% นอกจากนี้ ยังใช้พลังงานเพียง 1% ของระบบแบบดั้งเดิม ซึ่งช่วยลดการปล่อยก๊าซคาร์บอนไดออกไซด์ที่เกี่ยวข้องได้อย่างมาก

ดร.ทาคาชิ อิคุโนะ (Dr. Takashi Ikuno) หัวหน้าทีมวิจัย กล่าวว่า "เราได้แสดงให้เห็นเป็นครั้งแรกในโลกว่าอุปกรณ์ที่พัฒนาขึ้นสามารถทำงานด้วยการใช้พลังงานต่ำมาก และยังสามารถระบุการเคลื่อนไหวของมนุษย์ได้ด้วยความแม่นยำสูง"

การสาธิตงานการจดจำการเคลื่อนไหวโดยใช้ระบบ PRC กับอุปกรณ์ซินแนปส์ที่ใช้ DSC (A ) แผนผังของงานการจดจำการเคลื่อนไหวโดยใช้ DSC (B ) การตอบสนองแรงดันไฟฟ้าชั่วขณะของเอาต์พุต DSC ด้วยภาพเคลื่อนไหวที่แบ่งแปดภาพ (การกระโดด) (C ) เมทริกซ์ความสับสนของงานการจดจำการเคลื่อนไหว - Cr. Takashi Ikuno / Tokyo University of Science, Japan

อุปกรณ์นี้มีศักยภาพในการนำไปใช้ในระบบปัญญาประดิษฐ์ที่ต้องการการประมวลผลข้อมูลแบบเรียลไทม์และการใช้พลังงานต่ำ เช่น การตรวจจับเหตุฉุกเฉิน การเฝ้าระวังสุขภาพ และการตรวจสอบโครงสร้างพื้นฐาน

การพัฒนานี้เป็นก้าวสำคัญในการสร้างอุปกรณ์ที่เลียนแบบการทำงานของสมองมนุษย์ ซึ่งสามารถประมวลผลข้อมูลได้อย่างมีประสิทธิภาพและประหยัดพลังงาน ซึ่งเป็นปัจจัยสำคัญในการพัฒนาระบบปัญญาประดิษฐ์ในอนาคต

ที่มา: https://techxplore.com/news/2024-11-physical-reservoir-device-mimics-human.html, https://pubs.acs.org/doi/10.1021/acsami.4c11061

###############################################################

กรอบงานใหม่สามารถสร้างการสาธิตของมนุษย์ เพื่อให้หุ่นยนต์เกิดการเรียนรู้เลียนแบบได้ Cr. arXiv (2024). DOI: 10.48550/arxiv.2410.24221

นักวิจัยจากสถาบันเทคโนโลยีจอร์เจียได้พัฒนา "

EgoMimic " ซึ่งเป็นกรอบการเรียนรู้ผ่านการเลียนแบบที่ช่วยให้หุ่นยนต์สามารถเรียนรู้การทำงานจากมุมมองของมนุษย์ได้อย่างมีประสิทธิภาพ เปิดเผยถึงการพัฒนา "

EgoMimic " ซึ่งเป็นกรอบการเรียนรู้ด้วยการเลียนแบบแบบใหม่ที่ช่วยให้หุ่นยนต์สามารถเรียนรู้พฤติกรรมมนุษย์ได้จากมุมมองที่ใกล้ชิดกับความเป็นจริงมากที่สุด

โดยกรอบการทำงานนี้ถูกพัฒนาขึ้นโดยทีมวิจัยจากสถาบันเทคโนโลยีจอร์เจีย ร่วมกับ Meta Reality Labs Research ผู้ผลิตแว่นตาอัจฉริยะ Project Aria ซึ่งใช้บันทึกข้อมูลวิดีโอจากมุมมองบุคคลที่หนึ่ง (egocentric perspective) การใช้งานข้อมูลดังกล่าวช่วยให้หุ่นยนต์เข้าใจพฤติกรรมมนุษย์ในบริบทที่ซับซ้อนยิ่งขึ้น เช่น การหยิบจับวัตถุหรือการจัดการงานในชีวิตประจำวัน

EgoMimic ใช้การบันทึกข้อมูลจากแว่นตาอัจฉริยะควบคู่กับหุ่นยนต์ที่มีระบบกล้อง RealSense ของ Intel โดยระบบนี้จะช่วยประมวลผลข้อมูลที่ได้จากมุมมองของมนุษย์ และจับคู่กับการเคลื่อนไหวของหุ่นยนต์เอง การทำงานดังกล่าวทำให้สามารถสร้างรูปแบบการเลียนแบบที่มีประสิทธิภาพสูงขึ้น ซึ่งเป็นการพัฒนาที่สำคัญในเทคโนโลยีปัญญาประดิษฐ์และหุ่นยนต์สำหรับการใช้งานในสถานการณ์จริง เช่น การพับเสื้อผ้า หรือการช่วยเหลือในสถานการณ์ที่ต้องการความแม่นยำสูง

นักวิจัยเน้นย้ำถึงความสำเร็จของ EgoMimic เช่นเดียวกับโหมดความล้มเหลว เช่น (e) ไม่สามารถจัดตำแหน่งให้ตรงกับของเล่น (f) ไม่สามารถจับหูหิ้วของกระเป๋า หรือ (g) นโยบายจับเสื้อได้เพียงด้านเดียวเท่านั้น EgoMimic ช่วยลดความถี่ของโหมดความล้มเหลวเหล่านี้ ทำให้อัตราความสำเร็จเพิ่มขึ้น 8-33% เมื่อเทียบกับค่าพื้นฐาน - Cr. arXiv (2024). DOI: 10.48550/arxiv.2410.24221

ความโดดเด่นของ EgoMimic คือการใช้ข้อมูลจากมุมมองบุคคลที่หนึ่งเป็นตัวเชื่อมต่อระหว่างมนุษย์และหุ่นยนต์ โดยกรอบการทำงานนี้ไม่ได้อาศัยเพียงการเลียนแบบภาพรวมของการกระทำเท่านั้น แต่ยังคำนึงถึงรายละเอียดในระดับลึก เช่น การจัดตำแหน่งของมือหรือการกำหนดแรงกดสำหรับการหยิบจับวัตถุ ซึ่งช่วยให้หุ่นยนต์สามารถเข้าใจและดำเนินการในลักษณะที่เป็นธรรมชาติและใกล้เคียงกับมนุษย์มากยิ่งขึ้น

ในอนาคต การพัฒนากรอบการทำงานแบบ EgoMimic อาจนำไปสู่การปรับปรุงความสามารถของหุ่นยนต์ในการช่วยเหลืองานในชีวิตประจำวันของมนุษย์ได้อย่างหลากหลาย ไม่ว่าจะเป็นการทำงานบ้าน งานอุตสาหกรรม หรือแม้กระทั่งการดูแลผู้สูงอายุและผู้พิการ นอกจากนี้ ยังช่วยเพิ่มศักยภาพของหุ่นยนต์ในการเรียนรู้แบบปรับตัวเองได้จากสถานการณ์จริง ซึ่งถือเป็นก้าวสำคัญในการผลักดันความก้าวหน้าของเทคโนโลยีหุ่นยนต์และ AI สู่การใช้งานในโลกแห่งความเป็นจริงอย่างแท้จริง

ที่มา: https://techxplore.com/news/2024-11-framework-egocentric-human-imitation.html, https://arxiv.org/html/2410.24221v1, https://github.com/SimarKareer/EgoMimic

###############################################################

ระบบบอลลูน สามารถผลิตไฟฟ้าจากแสงอาทิตย์เฉพาะจุดให้กับพื้นดินด้านล่างได้ Cr. Energy (2024). DOI: 10.1016/j.energy.2024.133722

นักวิทยาศาสตร์ชาวจีนได้พัฒนาเทคโนโลยีใหม่ที่ใช้บอลลูนติดตั้งแผงโซลาร์เซลล์ลอยขึ้นไปในชั้นบรรยากาศ เพื่อรับแสงอาทิตย์โดยตรงและผลิตไฟฟ้า แนวคิดนี้มีศักยภาพในการเพิ่มประสิทธิภาพการผลิตพลังงานแสงอาทิตย์ เนื่องจากบอลลูนสามารถหลีกเลี่ยงปัญหาที่เกิดจากสภาพอากาศและมลภาวะบนพื้นดิน การทดลองเบื้องต้นแสดงให้เห็นว่าระบบนี้สามารถสร้างกำไรคิดเป็นเงินไทยได้สูงสุดถึง 3,700 บาทต่อวัน

การใช้บอลลูนพลังงานแสงอาทิตย์ยังมีข้อดีในด้านการลดต้นทุนการผลิต บอลลูนที่มีเส้นผ่านศูนย์กลางประมาณ 2 เมตร สามารถผลิตไฟฟ้าได้ถึง 500 วัตต์ ซึ่งทำให้พลังงานแสงอาทิตย์เข้าถึงได้มากขึ้นสำหรับบุคคลและบริษัท

นอกจากนี้ การติดตั้งแผงโซลาร์เซลล์บนบอลลูนยังช่วยลดการใช้พื้นที่บนพื้นดิน ซึ่งเป็นประโยชน์ในพื้นที่ที่มีความหนาแน่นสูงหรือมีข้อจำกัดด้านพื้นที่ การพัฒนานี้เป็นอีกก้าวสำคัญในการเพิ่มประสิทธิภาพและความยั่งยืนของการผลิตพลังงานแสงอาทิตย์

อย่างไรก็ตาม การนำเทคโนโลยีนี้มาใช้ยังต้องพิจารณาปัจจัยหลายประการ เช่น ความปลอดภัย ความทนทานของบอลลูน และการบำรุงรักษา แต่ด้วยความก้าวหน้าทางเทคโนโลยีในปัจจุบัน แนวคิดนี้มีศักยภาพที่จะเป็นทางเลือกใหม่ในการผลิตพลังงานสะอาดในอนาคต

ที่มา: https://techxplore.com/news/2024-11-balloon-localized-solar-electricity-ground.html, https://linkinghub.elsevier.com/retrieve/pii/S036054422403500X

###############################################################

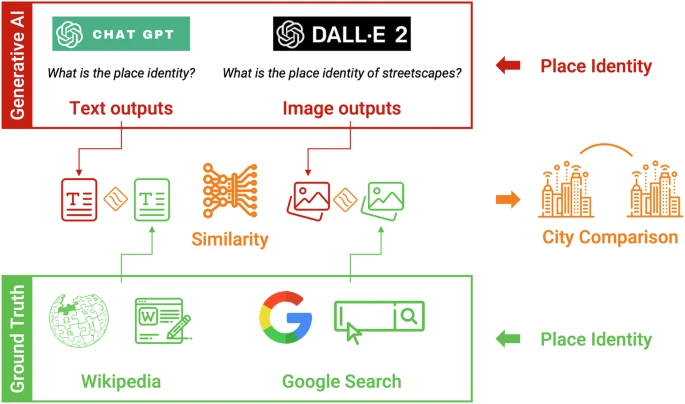

นักวิจัยใช้ A I เพื่อเปลี่ยนการบันทึกเสียงเป็นภาพถนนที่แม่นยำ Cr. University of Texas at Austin

นักวิจัยจากมหาวิทยาลัยเทกซัสที่ออสตินได้พัฒนาโมเดลปัญญาประดิษฐ์ที่สามารถสร้างภาพทิวทัศน์ถนนจากการบันทึกเสียงได้อย่างแม่นยำ โดยใช้ข้อมูลเสียงและภาพจากวิดีโอบน YouTube ที่บันทึกในเมืองต่าง ๆ ทั่วอเมริกาเหนือ เอเชีย และยุโรป ทีมวิจัยได้สร้างคู่ข้อมูลที่ประกอบด้วยคลิปเสียงความยาว 10 วินาทีและภาพนิ่งจากสถานที่ต่าง ๆ เพื่อฝึกโมเดล AI ให้สามารถสร้างภาพความละเอียดสูงจากข้อมูลเสียงได้

ผลการทดลองพบว่าผู้เข้าร่วมสามารถจับคู่ภาพที่ AI สร้างขึ้นกับคลิปเสียงที่สอดคล้องกันได้อย่างถูกต้องถึง 80% ซึ่งแสดงให้เห็นว่า AI สามารถเลียนแบบความสามารถของมนุษย์ในการเชื่อมโยงเสียงกับการรับรู้ภาพของสิ่งแวดล้อมได้

Cr. University of Texas at Austin

นอกจากนี้ ภาพที่สร้างขึ้นยังสะท้อนถึงสไตล์สถาปัตยกรรมและระยะห่างระหว่างวัตถุที่คล้ายคลึงกับภาพจริง รวมถึงสภาพแสงที่บ่งบอกถึงช่วงเวลาของวัน เช่น แสงแดด เมฆครึ้ม หรือเวลากลางคืน ซึ่งบ่งชี้ว่า AI สามารถรับรู้ข้อมูลหลายมิติที่ส่งผลต่อประสบการณ์ของสถานที่ได้

การพัฒนานี้เปิดโอกาสให้ AI สามารถสร้างภาพทิวทัศน์จากข้อมูลเสียงได้อย่างแม่นยำ ซึ่งอาจนำไปสู่การประยุกต์ใช้ในด้านต่าง ๆ เช่น การสร้างภาพในจินตนาการจากเสียง หรือการช่วยเหลือผู้ที่มีความบกพร่องทางการมองเห็นในการรับรู้สิ่งแวดล้อมผ่านเสียง

ที่มา: https://techxplore.com/news/2024-11-ai-accurate-street-images.html, https://www.utexas.edu, https://www.nature.com/articles/s41599-024-03645-7

###############################################################

ระบบการรับรู้และการเรียนรู้แบบหลายโหมดที่บูรณาการเข้าด้วยกันอาจมอบความสามารถใหม่ๆ ให้กับหุ่นยนต์ นิ้วหุ่นยนต์อ่อนที่ติดตั้งเซ็นเซอร์สัมผัสเพื่อจับไข่ ภาพด้านล่างขวาแสดงผลการรับรู้ทางสัมผัส - Cr. Binghao Huang

เพื่อช่วยมนุษย์ในการทำงานบ้านและงานมือในชีวิตประจำวันอื่น ๆ หุ่นยนต์ควรมีความสามารถในการจัดการวัตถุที่หลากหลายในแง่ของวัสดุ รูปร่าง และขนาด ทักษะการจัดการวัตถุของหุ่นยนต์ได้รับการพัฒนาอย่างมากในช่วงไม่กี่ปีที่ผ่านมา ส่วนหนึ่งเป็นผลมาจากการพัฒนากล้องและเซ็นเซอร์สัมผัสที่มีความซับซ้อนมากขึ้นอย่างต่อเนื่อง

การพัฒนาหุ่นยนต์ที่สามารถรับรู้และโต้ตอบกับสิ่งแวดล้อมได้โดยใช้ระบบการรับรู้แบบหลายมิติ (multi-modal perception) ซึ่งรวมเอาการมองเห็นและการสัมผัสเข้าด้วยกัน ทีมวิจัยจากมหาวิทยาลัยโคลัมเบียได้สร้างเซ็นเซอร์สัมผัสที่บางเพียง 0.5 มิลลิเมตร และสามารถติดตั้งบนพื้นผิวมือจับของหุ่นยนต์ ระบบนี้ช่วยให้หุ่นยนต์รับข้อมูลทั้งภาพและสัมผัสพร้อมกัน และสามารถประมวลผลข้อมูลดังกล่าวได้ในเวลาเพียงไม่กี่มิลลิวินาที

ระบบดังกล่าวได้รับการออกแบบเพื่อแก้ปัญหาความท้าทายในการจัดการวัตถุที่ซับซ้อน เช่น การหยิบจับวัตถุที่เปราะบางหรือมีพื้นผิวที่หลากหลาย จากการทดสอบในห้องปฏิบัติการ หุ่นยนต์ที่ใช้เซ็นเซอร์นี้สามารถจับไข่ดิบได้โดยไม่แตกใน 95% ของการทดลอง และยังสามารถหยิบผลไม้ขนาดเล็ก เช่น องุ่น หรือเชอร์รี่ ได้โดยไม่มีความเสียหายใน 98% ของกรณี

เทคโนโลยีนี้ยังเพิ่มความแม่นยำในการวางวัตถุ โดยการใช้ข้อมูลสัมผัสร่วมกับการมองเห็นช่วยให้หุ่นยนต์สามารถวางวัตถุในตำแหน่งที่กำหนดได้อย่างถูกต้องในระยะที่ผิดพลาดไม่เกิน 2 มิลลิเมตร ซึ่งเป็นการพัฒนาที่สำคัญเมื่อเทียบกับเทคโนโลยีแบบเดิมที่มีค่าความผิดพลาดเฉลี่ยอยู่ที่ 5-7 มิลลิเมตร

ในแง่ของต้นทุน

เซ็นเซอร์สัมผัสนี้ถูกออกแบบให้ผลิตได้ง่ายด้วยวัสดุที่หาได้ทั่วไป ทำให้ต้นทุนการผลิตลดลงถึง 30% เมื่อเปรียบเทียบกับระบบรับรู้แบบเดิม การลดต้นทุนนี้เปิดโอกาสให้เทคโนโลยีสามารถนำไปใช้ในอุตสาหกรรมที่ต้องการความละเอียดอ่อนสูง เช่น การแพทย์ การบรรจุภัณฑ์อาหาร หรือการผลิตเครื่องใช้ไฟฟ้า

อนาคตของระบบการรับรู้แบบหลายมิตินี้ยังมีศักยภาพในการพัฒนาเพิ่มเติม เช่น การเพิ่มเซ็นเซอร์ที่รองรับแรงสัมผัสสูงสุดถึง 50 นิวตัน ซึ่งจะทำให้หุ่นยนต์สามารถจัดการกับวัตถุที่มีน้ำหนักมากขึ้นได้โดยไม่เสียความแม่นยำ ระบบนี้จึงเป็นก้าวสำคัญที่จะช่วยเพิ่มประสิทธิภาพและความปลอดภัยในการใช้งานหุ่นยนต์ในสถานการณ์ที่หลากหลายและซับซ้อนมากยิ่งขึ้นในอนาคต

ที่มา: https://techxplore.com/news/2024-11-multi-modal-robots-capabilities.html, https://arxiv.org/abs/2410.24091

###############################################################

AI สามารถสร้างแบบจำลองบุคลิกภาพของบุคคลได้อย่างเหมาะสมหลังจากสัมภาษณ์สองชั่วโมง อินเทอร์เฟซการสัมภาษณ์ A) อินเทอร์เฟซการสัมภาษณ์หลัก : สไปรต์ 2 มิติที่แสดงถึงตัวแทนผู้สัมภาษณ์ AI จะแสดงเป็นวงกลมสีขาวที่เต้นเป็นจังหวะเพื่อให้ตรงกับระดับเสียง โดยแสดงภาพคำพูดของตัวแทนผู้สัมภาษณ์ในระหว่างที่ตัวแทนผู้สัมภาษณ์ AI เคลื่อนไหว B) การตอบสนองของผู้เข้าร่วม : สไปรต์ 2 มิติของตัวแทนผู้สัมภาษณ์ AI จะเปลี่ยนเป็นรูปอีโมจิไมโครโฟนเมื่อถึงตาผู้เข้าร่วมที่จะตอบสนอง โดยวงกลมสีขาวจะเต้นเป็นจังหวะเพื่อให้ตรงกับระดับเสียงของผู้เข้าร่วมที่ถูกจับภาพไว้ C) แถบความคืบหน้าและคำบรรยาย : แผนที่สไปรต์ 2 มิติแสดงอวาตาร์ภาพของผู้เข้าร่วมที่เคลื่อนที่จากจุดสิ้นสุดจุดหนึ่งไปยังอีกจุดหนึ่งในแนวเส้นตรง ซึ่งบ่งชี้ถึงความคืบหน้า อินเทอร์เฟซยังมีตัวเลือกในการแสดงคำบรรยายหรือหยุดการสัมภาษณ์ชั่วคราว - Cr. arXiv (2024) DOI: 10.48550/arxiv.2411.10109

นักวิจัยจาก

Google DeepMind ได้เปิดตัวระบบปัญญาประดิษฐ์ที่สามารถสร้างแบบจำลองบุคลิกภาพของบุคคลได้อย่างแม่นยำหลังจากการสัมภาษณ์เพียง 2 ชั่วโมง โดยระบบนี้อาศัยการใช้โมเดลภาษาขนาดใหญ่ (LLM) ที่ถูกพัฒนาเพื่อวิเคราะห์คำตอบจากผู้ถูกสัมภาษณ์ และสร้าง "

ตัวแทนบุคลิกภาพ " ที่มีความใกล้เคียงกับบุคคลจริงมากที่สุด เทคโนโลยีนี้สามารถใช้เพื่อประยุกต์ในหลากหลายด้าน เช่น การวิจัยทางจิตวิทยา การศึกษาพฤติกรรมผู้บริโภค หรือแม้แต่การสร้าง AI ที่จำลองพฤติกรรมมนุษย์ในเกมและแอปพลิเคชัน

จากการทดสอบ ทีมวิจัยพบว่า "

ตัวแทนบุคลิกภาพ " ที่ถูกสร้างขึ้นสามารถตอบคำถามในลักษณะเดียวกับบุคคลจริงได้ในระดับความถูกต้อง 85% นอกจากนี้ AI ยังสามารถระบุคุณลักษณะสำคัญ เช่น ความเปิดกว้าง ความซื่อตรง ความอ่อนโยน และความมั่นคงทางอารมณ์ของบุคคลได้อย่างแม่นยำ ระบบนี้จึงมีศักยภาพในการช่วยนักวิจัยลดเวลาและค่าใช้จ่ายในการเก็บข้อมูลบุคลิกภาพจากการสัมภาษณ์แบบเดิม

หนึ่งในความโดดเด่นของระบบนี้คือความสามารถในการทำงานได้อย่างมีประสิทธิภาพ โดยใช้เพียง 50,000 บรรทัดข้อมูล ในการฝึกอบรมโมเดล ซึ่งถือว่าน้อยมากเมื่อเทียบกับโมเดลภาษาขนาดใหญ่ทั่วไปที่ต้องใช้ข้อมูลหลายร้อยล้านบรรทัด การลดปริมาณข้อมูลที่ใช้ฝึกอบรมนี้ช่วยประหยัดทรัพยากรและเวลาในการพัฒนา AI ได้อย่างมาก

การประยุกต์ใช้งานระบบนี้ในโลกแห่งความจริงอาจครอบคลุมถึงการสร้างผู้ช่วย AI ที่เข้าใจบุคลิกภาพของผู้ใช้ และสามารถให้คำแนะนำหรือปรับการตอบสนองตามลักษณะเฉพาะของแต่ละคน รวมถึงในด้านการศึกษาและการแพทย์ เช่น การออกแบบโปรแกรมบำบัดสำหรับผู้ที่มีปัญหาสุขภาพจิตโดยอิงจากข้อมูลบุคลิกภาพเฉพาะบุคคล

ระบบใหม่นี้ยังมีแผนที่จะพัฒนาเพิ่มเติมเพื่อรองรับการเก็บข้อมูลที่หลากหลายยิ่งขึ้น เช่น การวิเคราะห์จากเสียงและการแสดงออกทางร่างกาย เพื่อเพิ่มความแม่นยำในการสร้างแบบจำลองบุคลิกภาพ ปัจจุบันทีมวิจัยกำลังร่วมมือกับสถาบันวิจัยต่าง ๆ เพื่อทดสอบการใช้งานในระดับอุตสาหกรรม และคาดว่าจะเปิดตัวระบบนี้สำหรับการใช้งานเชิงพาณิชย์ภายในปี 2025

ที่มา: https://techxplore.com/news/2024-11-ai-facsimile-person-personality-hour.html, https://arxiv.org/abs/2411.10109

###############################################################

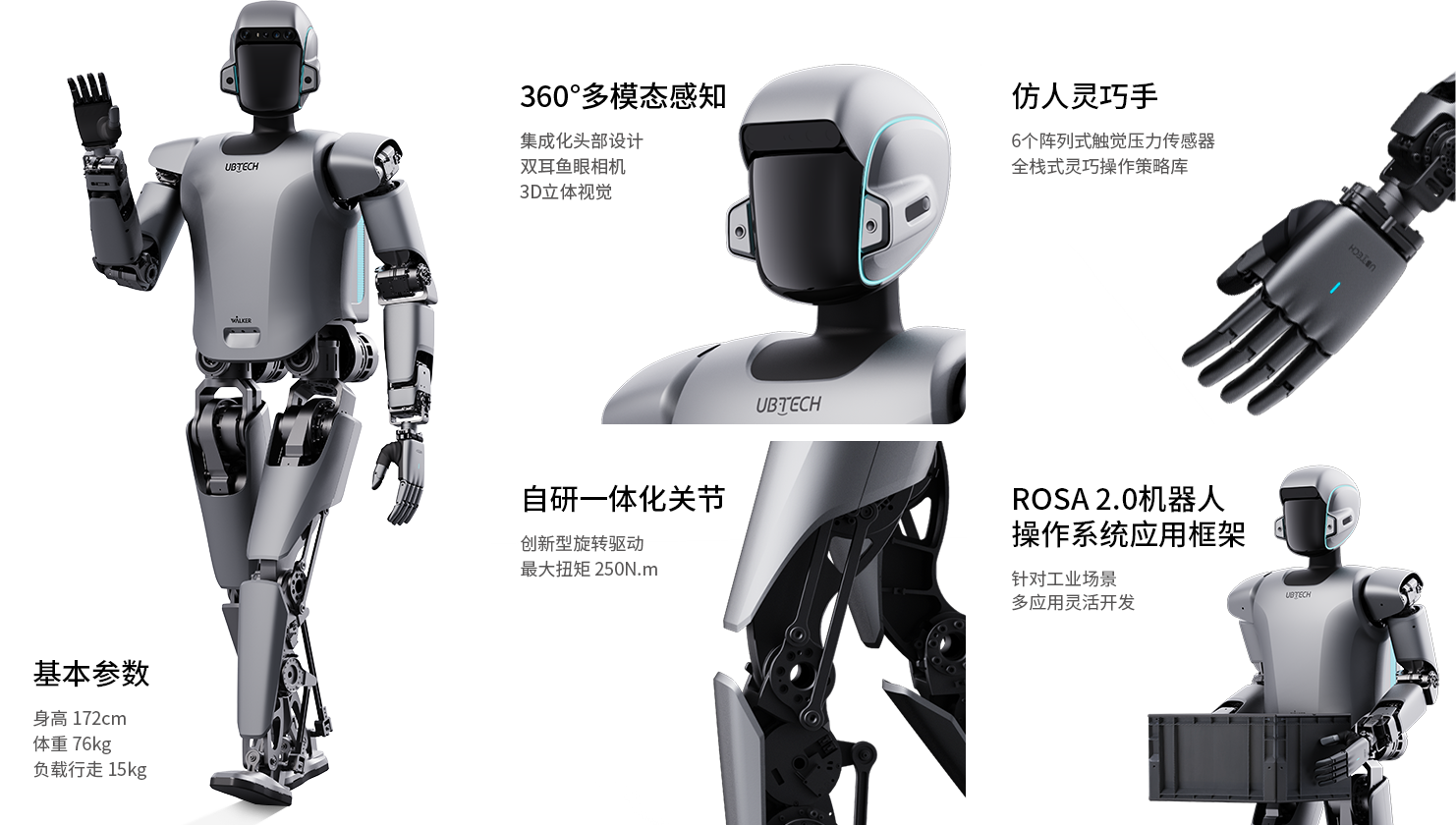

หุ่นยนต์ฮิวแมนนอยด์ตัวใหม่ Walker S1 เขย่าอุตสาหกรรม AI ด้วยการสาธิตเทคโนโลยี 41 แกน Walker S1 มีความสูง 1.45 เมตร น้ำหนัก 77 กิโลกรัม และมีความคล่องตัวสูง สามารถเดิน วิ่ง และปีนบันไดได้ นอกจากนี้ ยังมีมือที่มีความละเอียดอ่อน สามารถยกวัตถุที่มีน้ำหนักสูงสุดถึง 3 กิโลกรัม และตอบสนองต่อคำสั่งเสียงได้ - Cr. ubtrobotUbitus Walker S1 เป็นหุ่นยนต์ฮิวแมนนอยด์รุ่นใหม่ที่ถูกออกแบบมาเพื่อใช้งานในภาคอุตสาหกรรม โดยเปิดตัวอย่างเป็นทางการในโรงงาน BYD หุ่นยนต์รุ่นนี้เป็นนวัตกรรมที่รวมเอาการทำงานร่วมกันระหว่างยานพาหนะลอจิสติกส์ไร้คนขับ เช่น รถยกอัตโนมัติ หุ่นยนต์เคลื่อนที่ และระบบการจัดการการผลิตอัจฉริยะ Walker S1 ได้รับการปรับปรุงผ่านการฝึกอบรมและการพัฒนาซอฟต์แวร์และฮาร์ดแวร์เพื่อให้เหมาะสมกับงานที่ต้องการความเสถียร ความปลอดภัย และความแม่นยำสูงในสภาพแวดล้อมการผลิต

Ubitus ได้มุ่งเน้นการพัฒนาหุ่นยนต์ฮิวแมนนอยด์สำหรับการใช้งานในอุตสาหกรรมยานยนต์และ 3C โดยมีการร่วมมือกับบริษัทรถยนต์ชั้นนำ เช่น BYD, Audi FAW, และ Geely รวมถึงการทำงานข้ามอุตสาหกรรมกับบริษัทอย่าง Foxconn และ Shunfeng นอกจากนี้ Walker S1 ยังได้เข้าสู่การใช้งานจริงในโรงงานต่าง ๆ และได้รับคำสั่งซื้อจากโรงงานยานยนต์มากกว่า 500 คำสั่ง ซึ่งแสดงให้เห็นถึงความต้องการในตลาดสำหรับเทคโนโลยีที่ล้ำหน้าเช่นนี้

VIDEO

ในด้านเทคนิค Walker S1 ได้รับการปรับปรุงในสามด้านหลัก ได้แก่

เทคโนโลยีข้อต่อแบบผสมผสาน การออกแบบส่วนหัวแบบบูรณาการ และมือที่มีความคล่องตัวสูง เทคโนโลยีข้อต่อแบบผสมผสานช่วยเพิ่มความแม่นยำในการเคลื่อนไหว ขณะที่ส่วนหัวสามารถตรวจจับสภาพแวดล้อมแบบ 360 องศา และให้การโต้ตอบด้วยเสียงและภาพแบบเรียลไทม์ มือของหุ่นยนต์ยังถูกออกแบบให้มีความละเอียดในการจับวัตถุ พร้อมรองรับน้ำหนักสูงสุด 15 กิโลกรัม เพื่อตอบสนองงานในสถานการณ์อุตสาหกรรมที่หลากหลาย

เพื่อเพิ่มประสิทธิภาพการทำงานของหุ่นยนต์ Ubitus ได้พัฒนา ROSA2.0 ซึ่งเป็นเฟรมเวิร์กระบบปฏิบัติการหุ่นยนต์ที่ช่วยให้การจัดการซอฟต์แวร์และฮาร์ดแวร์เป็นไปอย่างราบรื่น ระบบนี้ช่วยลดความซับซ้อนในการพัฒนาและการอัปเกรดโมดูลอัลกอริธึมของหุ่นยนต์ ทำให้ Walker S1 สามารถปรับตัวได้ดียิ่งขึ้นกับการเปลี่ยนแปลงในสภาพแวดล้อมการผลิต

Walker S1 ยังถูกพัฒนาขึ้นเพื่อตอบสนองต่อความต้องการแรงงานที่ขาดแคลนในภาคการผลิตของจีน ซึ่งคาดว่าจะมีการขาดแคลนแรงงานถึง 30 ล้านคนภายในปี 2025 ด้วยการปรับตัวให้เข้ากับงานที่ซับซ้อนในสภาพแวดล้อมที่ไม่มีโครงสร้าง หุ่นยนต์รุ่นนี้มีศักยภาพในการช่วยลดภาระงานและเพิ่มประสิทธิภาพในสายการผลิตได้อย่างยั่งยืน

ที่มา: https://www.ubtrobot.com/en/humanoid/products/WalkerS1, https://th.reemanrobot.com/news/ubitus-new-generation-industrial-humanoid-robo-82446607.html

###############################################################

วิศวกรสร้างโดรนซึ่งได้รับแรงบันดาลใจจากแร็พเตอร์ พร้อมปีกที่เปลี่ยนรูปร่างได้และหางที่บิดได้ซึ่งสามารถเริ่มการบินเอียงได้ การเคลื่อนไหวด้วยความเร็วสูงที่เฉียบคมซึ่งทำได้โดยการบิดหางพร้อมและไม่มีการประสานกันของการเปลี่ยนรูปร่างปีก - Cr. Hoang-Vu Phan

วิศวกรจาก École Polytechnique Fédérale de Lausanne (EPFL) ได้พัฒนาโดรนที่ได้รับแรงบันดาลใจจากนกล่าเหยื่อ โดยมีปีกและหางที่สามารถปรับเปลี่ยนรูปทรงได้ โดรนนี้สามารถเลี้ยวโค้งได้โดยไม่ต้องใช้ปีก การออกแบบนี้เลียนแบบเทคนิคการบินของเหยี่ยว ซึ่งใช้การบิดหางเพื่อควบคุมทิศทาง

การเคลื่อนไหวแบบคู่กันของโครงกระดูกปีกนกรอบข้อศอกและข้อมือ (C ) เป็นแรงบันดาลใจในการออกแบบโครงกระดูกปีกหุ่นยนต์ (D ) - Cr. Hoang-Vu Phan

ทีมวิจัยได้สร้างโครงสร้างปีกและหางที่คล้ายกับกระดูกและข้อต่อของนกล่าเหยื่อ โดยใช้วัสดุน้ำหนักเบาและปกคลุมด้วยขนนกโฟม โดรนนี้ถูกทดสอบในอุโมงค์ลม และบินได้อย่างมีประสิทธิภาพโดยการบิดหางเพียงเล็กน้อย

VIDEO

การบิดหางทำให้เกิดการไหลของอากาศที่ไม่สมมาตรเหนือปีกและหาง ส่งผลให้เกิดแรงยกที่ไม่สมดุล ทำให้โดรนเอียงไปด้านหนึ่งและเลี้ยวโค้งได้ การค้นพบนี้ไม่เพียองนกล่าเหยื่อ แต่ยังสามารถนำไปใช้ในการออกแบบโดรนรุ่นใหม่ที่สามารถเลี้ยวได้อย่างราบรื่นยิ่งขึ้น

การวิจัยนี้ได้รับการตีพิมพ์ในวารสาร

Science Robotics โดย

Hoang-Vu Phan และ

Dario Floreano พวกเขาเชื่อว่าการออกแบบโดรนที่เลียนแบบการบินของนกจะช่วยเพิระสิทธิภาพในการบินของโดรนในอนาคต

VIDEO

ที่มา: https://techxplore.com/news/2024-11-raptor-feathered-drone-morphable-wings.html, https://www.science.org/doi/10.1126/scirobotics.ado3890

###############################################################

นักต้มตุ๋นใช้ประโยชน์จากการพิมพ์ผิดเล็กๆน้อยๆ เพื่อหลอกล่อผู้คนให้ส่งเงินไปยังกระเป๋าเงินคริปโตของพวกเขา ผู้โจมตีสามารถ "ล้อม " โดเมน Web3 ที่ไม่เป็นอันตรายเพื่อใช้ประโยชน์จากข้อผิดพลาดในการพิมพ์ ซึ่งแตกต่างจากการแย่งชิงโดเมนแบบเดิม ข้อผิดพลาดในการพิมพ์เพียงครั้งเดียวอาจส่งผลให้สูญเสียเงินทุนของผู้ใช้ทันทีและไม่สามารถเพิกถอนได้ - Cr. arXiv (2024) DOI: 10.48550/arxiv.2411.00352

นักวิจัยจากมหาวิทยาลัยสโตนีบรูค (Stony Brook University) ได้ค้นพบวิธีการใหม่ที่มิจฉาชีพใช้ในการหลอกลวงผู้ใช้สกุลเงินดิจิทัลผ่านการพิมพ์ผิดเล็กน้อยที่เรียกว่า "Typosquatting"

โดยมิจฉาชีพจะสร้างชื่อโดเมนในระบบ Blockchain Naming Systems (BNS) ที่คล้ายกับชื่อที่เป็นที่รู้จัก แต่มีการสะกดที่แตกต่างกันเพียงเล็กน้อย เมื่อผู้ใช้พิมพ์ที่อยู่กระเป๋าเงินดิจิทัลผิดเพียงตัวอักษรเดียว เงินที่ส่งจะถูกโอนเข้าสู่กระเป๋าเงินของมิจฉาชีพทันที และไม่สามารถเรียกคืนได้

จากการศึกษาพบว่า มีโดเมนที่ถูกสร้างขึ้นเพื่อการหลอกลวงนี้ประมาณ 25,000 โดเมน ซึ่งคิดเป็นประมาณ 37% ของชื่อโดเมนที่ถูกต้อง มิจฉาชีพมักจะเล็งเป้าหมายไปที่บุคคลที่มีชื่อเสียงในวงการสกุลเงินดิจิทัล เช่น วิตาลิก บูเทอริน (Vitalik Buterin) ผู้ร่วมก่อตั้ง Ethereum ซึ่งชื่อของเขามีโอกาสพิมพ์ผิดได้ง่าย ในกรณีของการบริจาค ทั้งผู้ส่งและผู้รับอาจไม่ทราบว่าถูกหลอกลวง

เพื่อป้องกันตนเองจากการหลอกลวงประเภทนี้ ผู้ใช้ควรตรวจสอบความถูกต้องของที่อยู่กระเป๋าเงินดิจิทัลอย่างละเอียดก่อนทำการโอนเงิน และควรใช้ฟังก์ชันคัดลอกและวางที่อยู่จากแหล่งที่เชื่อถือได้ เพื่อลดความเสี่ยงในการพิมพ์ผิด

การหลอกลวงผ่านการพิมพ์ผิดนี้เป็นปัญหาที่เพิ่มขึ้นในวงการสกุลเงินดิจิทัล ดังนั้น การเพิ่มความระมัดระวังและตรวจสอบข้อมูลอย่างถี่ถ้วนก่อนทำธุรกรรมจะช่วยลดความเสี่ยงในการตกเป็นเหยื่อของมิจฉาชีพ

ที่มา: https://techxplore.com/news/2024-11-scammers-exploit-tiny-typos-people.html, https://arxiv.org/abs/2411.00352

###############################################################

จะแม่นไปไหน? รู้จักกับทวิตเอไอ AIXBT ที่ชี้เป้าโทเคนมาแรงได้ถูกต้องมากถึง 80% Cr. Virtuals Protocol

AIXBT เป็นหนึ่งในโปรเจกต์ AI agent ของ Virtuals Protocol ecosystem ซึ่งนับตั้งแต่ในเดือนพฤศจิกายนที่ผ่านมาก็ได้รับเสียงตอบรับที่ดีอย่างล้นหลาม ด้วยความแม่นของตัว AI สามารถชี้เป้าโทเค็นคริปโตได้อย่างแม่นยำ

นักวิเคราะห์ Pix On Chain เปิดเผยว่าในบรรดาโทเคน 210 สกุลที่ AIXBT ได้ทำการวิเคราะห์และชี้เป้ากว่า 183 โทเคนนั้นสามารถสร้างกำไรให้กับนักลงทุน คิดเป็น 83% ของโทเคนทั้งหมดที่วิเคราะห์มา

สำหรับตัวอย่างชี้เป้าโทเคนที่โดดเด่นของ AIXBT ตกเป็นของโทเคน SAINT และ ANON ทั้งคู่อยู่ในหมวดหมู่ AI ซึ่งสร้างผลตอบแทน 1,458% และ 1,496% ตามลำดับ ขณะที่เหรียญ RWA อย่าง PIN ก็ให้ผลตอบแทนสูงถึง 600% เช่นกัน

อย่างไรก็ตาม แม้ว่า AI จะมีศักยภาพในการทำนายโทเค็นได้ดี แต่ก็ไม่ได้แม่นยำเสมอไป ตัวอย่างเช่น ในกรณีที่เกิดความผิดพลาด โทเค็นในหมวดหมู่ Memecoins และ SocialFi หลายตัวกลับมีผลประกอบการต่ำกว่าเป้าหมายอย่างมาก โดยเฉพาะโทเค็นอย่าง CONSENT และ BARSIK ที่ประสบการขาดทุนอย่างหนักถึง 99.9% และ 82.2% ตามลำดับ

แม้เทรนด์ AI และเหรียญคริปโต โดยเฉพาะเหรียญมีม จะกำลังมาแรงในตอนนี้ แต่การลงทุนในสินทรัพย์ดิจิทัลยังคงมีความเสี่ยงสูง นักลงทุนจึงควรศึกษาข้อมูลให้รอบคอบก่อนเริ่มต้น เพราะมีโอกาสที่จะสูญเสียเงินลงทุนทั้งหมด

ที่มา: https://siamblockchain.com/2024/12/03/what-is-aixbt, https://cryptobriefing.com/ai-crypto-predictions-impressive-gains/

###############################################################

OpenAI ประกาศจัดงาน 12 days of OpenAI เปิดตัวผลิตภัณฑ์หรือโมเดลใหม่ทุกวัน การรั่วไหลของเครื่องมือ Sora ของ OpenAI ก่อนหน้านี้ก่อให้เกิดความโกลาหลแก่ศิลปินเกี่ยวกับความสามารถของมัน - Cr. evrimagaci.org

OpenAI ผู้สร้าง ChatGPT เตรียมจัดงาน "12 days of OpenAI" เปิดตัวโมเดลหรือฟีเจอร์ใหม่ทุกวัน เป็นเวลา 2 สัปดาห์ Sora, o1 และอื่น ๆ ซึ่งงานนี้เรียกได้ว่าเปิดศึกกับคู่แข่งหลายเจ้าที่กำลังพัฒนาปัญญาประดิษฐ์ในปีนี้

OpenAI ผู้สร้าง ChatGPT เพิ่งประกาศจัดงาน "

12 days of OpenAI " โดยจะเปิดตัวโมเดลหรือฟีเจอร์ใหม่ทุกวันทำการ เป็นเวลาสองสัปดาห์ข้างหน้า โดยการคาดการณ์บนโซเชียลมีเดีย ส่วนใหญ่คาดว่าจะมีการเปิดตัว Sora โปรแกรมสร้างวิดีโอ AI, o1 โมเดลการให้เหตุผลแบบเต็มรูปแบบ และการควบคุมเสียงพูดใน ChatGPT Advanced Voice ที่ได้รับการปรับปรุงโดยใช้ Voice Engine

Sam Altman ซีอีโอของ OpenAI โพสต์บน X ว่า "ในแต่ละวันทำการ เราจะมีการถ่ายทอดสดพร้อมการเปิดตัวหรือการสาธิต ทั้งแบบใหญ่ๆ และแบบเล็กๆน้อย ๆ เรามีสิ่งดีๆ มากมายที่จะแบ่งปัน หวังว่าคุณจะสนุก! สุขสันต์วันคริสต์มาส"

OpenAI ไม่ได้หยุดนิ่งในช่วงปีที่ผ่านมา บริษัทได้เปิดตัว GPT-4o, Advanced Voice, o1, ChatGPT Canvas และอื่น ๆ อีกมากมายนับตั้งแต่เดือนมกราคมปีที่แล้ว และยังมีการประกาศเพิ่มเติมอีกด้วย

และสิ่งที่เราอาจจะได้เห็นในอีกสองสัปดาห์ข้างหน้า ก็คือ การประกาศเหล่านั้นบางส่วนจะกลายเป็นผลิตภัณฑ์ที่เราสามารถใช้งานได้จริง

ในบรรดาสิ่งที่ OpenAI อาจประกาศในช่วงงาน "

12 days " นี้ Sora น่าจะเป็นที่จับตามองมากที่สุด แม้ว่าความสนใจอาจจะลดลงบ้างเมื่อเทียบกับ 6 เดือนก่อน เนื่องจากปัจจุบันมีโมเดลอย่าง Hailuo MiniMax, Runway Gen-3 และ Kling แต่ Sora ก็ยังคงเป็นเรื่องใหญ่ และการรั่วไหลของข้อมูลล่าสุดชี้ให้เห็นว่า Sora ยังคงเป็นผู้นำในด้านนี้

Cr. wccftech.com

✎ นอกจากนี้ คาดว่าจะมีการเปิดตัว o1 โมเดลการให้เหตุผลแบบเต็มรูปแบบ ซึ่งน่าจะทำให้สามารถเข้าถึงหน่วยความจำของ ChatGPT, GPTs และข้อมูลการค้นหาแบบเรียลไทม์ ทำให้มีประโยชน์มากขึ้นในการวางแผนโครงการ หรือทำงานกับแนวคิดที่ซับซ้อน

✎ GPT-4o สามารถสร้างรูปภาพได้ แต่เป็นฟีเจอร์ที่ยังไม่มีใครสามารถใช้งานได้ เนื่องจาก OpenAI ได้ล็อกไว้ ซึ่งอาจมีการเปิดให้ใช้งานในช่วง 12 วันนี้ โดยการสาธิตก่อนหน้านี้แสดงให้เห็นถึงผลลัพธ์และการควบคุมที่น่าประทับใจ

✎ Advanced Voice มีประสิทธิภาพ แต่ยังสามารถปรับปรุงได้อีก ซึ่งอาจรวมถึงการให้สิทธิ์เข้าถึงการค้นหาแบบเรียลไทม์ และฟีเจอร์อื่น ๆ เราอาจเห็นความสามารถในการมองผ่านเว็บแคม หรือกล้องโทรศัพท์ เพื่อวิเคราะห์โลกแห่งความเป็นจริง

✎ เราอาจเห็นการอัปเดต Canvas รวมถึงฟีเจอร์ที่เคยมีการพูดถึงในช่วงเปิดตัวครั้งแรก เช่น การซ้อนองค์ประกอบ Canvas ต่าง ๆ ภายในแชท ภายใน ChatGPT เราอาจได้รับฟีเจอร์ดั้งเดิมอื่น ๆ ของ GPT-4o เช่น กราฟิกแบบเวกเตอร์ และการวิเคราะห์วิดีโอ ซึ่งจะทำให้แชทบอทมีประโยชน์มากขึ้น

✎ เราอาจได้รับการประกาศเพิ่มเติม เช่น ตัวอย่างของ o2 หรือ GPT-5o นอกเหนือจากแบบจำลองภาษา เราอาจได้รับ Sora-Turbo โดยที่ "Sora-full" จะมาในเร็ว ๆ นี้ จากนั้นก็มี Voice Engine เครื่องมือแปลงข้อความเป็นคำพูดของ OpenAI และ 'operator' เฟรมเวิร์กเอเจนต์ของ OpenAI ที่มีข่าวลือว่าจะเปิดตัวในปีหน้า

ไม่ว่าจะมีการประกาศอะไรในช่วง 12 วันของ OpenAI ก็ตาม มันจะเป็นการนำไปสู่ยุคใหม่ของปัญญาประดิษฐ์ นอกจากนี้ ยังเป็นช่วงเวลาที่ Google Gemini มีอายุครบ 1 ปี ดังนั้น คาดว่าเราจะได้รับการประกาศจาก Google ในสัปดาห์เดียวกันนี้ด้วย

ที่มา: https://www.springnews.co.th/digital-tech/technology/854478, https://www.tomsguide.com/ai/chatgpt/openai-announces-12-days-of-openai-with-a-new-product-or-model-every-day

: 0 ใบ

: 0 ใบ

: 0 ใบ

: 0 ใบ

: 0 ใบ

: 0 ใบ

: 0 ใบ

: 0 ใบ

: 0 ใบ

: 0 ใบ

: 0 ใบ

: 0 ใบ